En este artículo:

Google Edge TPU - ¿Qué es? ¿Y Cómo Funciona?

Assured Systems suministramos una gran variedad de productos que incorporan Google Edge TPU para una amplia gama de aplicaciones. Obtenga más información sobre qué es Google Edge TPU, cómo funciona y cómo podría beneficiarle.

La IA (Inteligencia Artificial) es una tecnología que permite a un ordenador pensar o actuar de un modo más "humano", tomando información de su entorno y decidiendo su respuesta en función de lo que aprende o percibe.

La IA (Inteligencia Artificial) es una tecnología que permite a un ordenador pensar o actuar de un modo más "humano", tomando información de su entorno y decidiendo su respuesta en función de lo que aprende o percibe.

Con el crecimiento en auge de los dispositivos conectados, combinado con la demanda de privacidad/confidencialidad, baja latencia y limitaciones de ancho de banda, los modelos de IA entrenados en la nube necesitan cada vez más ejecutarse en el borde, lo que significa simplemente que el dispositivo puede ejecutar la aplicación de IA de forma independiente sin tener que enviar ningún dato a un servidor utilizando una conexión a Internet.

¿Qué es Google Edge TPU?

Google Edge TPU es un ASIC (Circuito Integrado de Aplicación Específica, optimizado para ejecutar un tipo específico de aplicación) de Google diseñado para ejecutar IA en el perímetro. Ofrece un alto rendimiento en un espacio físico y energético reducido, lo que permite el despliegue de IA de alta precisión en el perímetro.

Google Edge TPU complementa los servicios Cloud TPU y Google Cloud para proporcionar una infraestructura de hardware y software de extremo a extremo, de la nube al extremo,  para facilitar el despliegue de las soluciones basadas en IA de los clientes.

para facilitar el despliegue de las soluciones basadas en IA de los clientes.

¿Pero cómo?

Pues bien, The Edge TPU permite desplegar inferencias ML de alta calidad en el edge, utilizando diversos productos de prototipado y producción de Coral.

La plataforma Coral para ML at the edge aumenta Cloud TPU y Cloud IoT de Google para proporcionar una infraestructura de extremo a extremo (cloud-to-edge, hardware y software) para facilitar el despliegue de las soluciones basadas en IA de los clientes. La plataforma Coral proporciona un completo conjunto de herramientas para desarrolladores que les permite compilar sus propios modelos o volver a entrenar varios modelos de IA de Google para la TPU Edge, combinando la experiencia de Google tanto en IA como en hardware.

Google Edge TPU complementa CPUs, GPUs, FPGAs y otras soluciones ASIC para ejecutar IA en el edge.

La nube frente al Edge

Ejecutar código en la nube significa que utilizas CPU, GPU y TPU de una empresa que las pone a tu disposición a través de tu navegador. La principal ventaja de ejecutar código en la nube es que se puede asignar la cantidad necesaria de potencia de cálculo para ese código específico (el entrenamiento de grandes modelos puede requerir mucho cálculo)

El borde es lo contrario de la nube. Significa que estás ejecutando tu código in situ (lo que básicamente significa que puedes tocar físicamente el dispositivo en el que se ejecuta el código). La principal ventaja de ejecutar código en el borde es que no hay latencia de red. Como los dispositivos IoT suelen generar datos con frecuencia, la ejecución de código en el borde es perfecta para las soluciones basadas en IoT

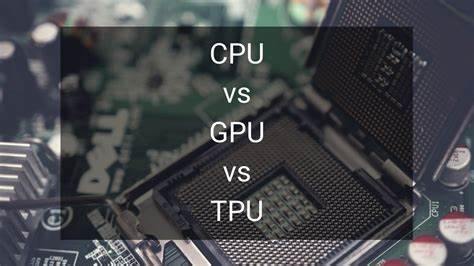

¿Cuál es la diferencia entre TPU, CPU y GPU?

Una TPU (Unidad de Procesamiento Tensorial) es otro tipo de unidad de procesamiento como una CPU o una GPU. Sin embargo, existen grandes diferencias entre ellas: la mayor es que la TPU es un ASIC. Y como probablemente ya sepas, las CPU y las GPU no son ASIC, ya que no están optimizadas para realizar un tipo específico de aplicación.

Una TPU (Unidad de Procesamiento Tensorial) es otro tipo de unidad de procesamiento como una CPU o una GPU. Sin embargo, existen grandes diferencias entre ellas: la mayor es que la TPU es un ASIC. Y como probablemente ya sepas, las CPU y las GPU no son ASIC, ya que no están optimizadas para realizar un tipo específico de aplicación.

Ya que estamos comparando CPUs, GPUs y TPUs, veamos rápidamente cómo realizan las operaciones de suma múltiple con su arquitectura:

- Una CPU realiza la operación de suma múltiple leyendo cada entrada y peso de la memoria, multiplicándolos con su ALU (unidad aritmética lógica), escribiéndolos de nuevo en la memoria y, por último, sumando todos los valores multiplicados. Las CPU modernas se ven reforzadas por una caché masiva, predicción de ramas y alta velocidad de reloj en cada uno de sus núcleos. Todo ello contribuye a reducir la latencia de la CPU.

- Sin embargo, una GPU no utiliza estas características que reducen la latencia. También necesita orquestar sus miles de ALU, lo que reduce aún más la latencia. En resumen, las GPU aumentan drásticamente su rendimiento paralelizando su cálculo a cambio de un aumento de su latencia.

- En cambio, el funcionamiento de una TPU es muy diferente. Sus ALU están directamente conectadas entre sí sin utilizar la memoria. Pueden dar directamente información de paso, lo que disminuye drásticamente la latencia.

En conclusión, la TPU Edge realiza la inferencia más rápido que cualquier otra arquitectura de unidad de procesamiento. No sólo es más rápida, sino también más respetuosa con el medio ambiente al utilizar la cuantización y menos operaciones de memoria.