Jetson Orin Nano löst Edge-KI-Herausforderungen der Einstiegsklasse - mit einer bis zu 80-fachen Leistung des Jetson Nano.

NVIDIA hat kürzlich die neuen Jetson Orin Nano System-on-Module vorgestellt, die einen neuen Standard für Edge-KI und Robotik der Einstiegsklasse setzen.

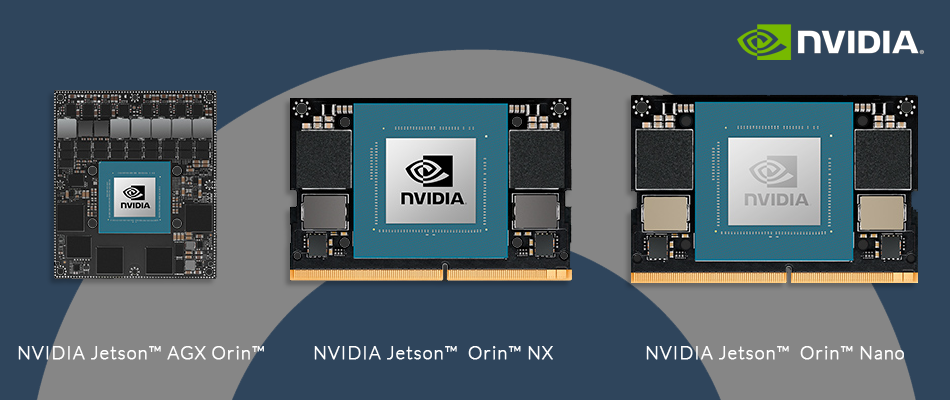

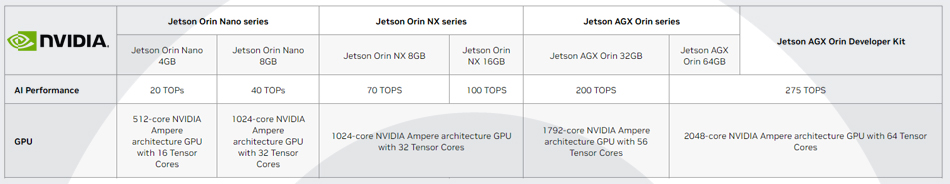

Zum ersten Mal umfasst die NVIDIA Jetson-Familie sechs Orin-basierte Produktionsmodule, die eine breite Palette von Edge-KI- und Robotik-Anwendungen unterstützen.

Dazu gehören der Orin Nano - der bis zu 40 Billionen Operationen pro Sekunde (TOPS) an KI-Leistung im kleinsten Jetson-Formfaktor liefert - bis hin zum AGX Orin, der 275 TOPS für fortschrittliche autonome Maschinen liefert.

Der Jetson Orin verfügt über eine NVIDIA Ampere-Architektur-GPU, Arm-basierte CPUs, Deep-Learning- und Vision-Beschleuniger der nächsten Generation, Hochgeschwindigkeitsschnittstellen, schnelle Speicherbandbreite und multimodale Sensorunterstützung.

Diese Leistung und Vielseitigkeit ermöglicht es mehr Kunden, Produkte zu vermarkten, die früher unmöglich schienen - von Ingenieuren, die KI-Anwendungen einsetzen, bis hin zu Entwicklern von Robotics Operating System (ROS), die intelligente Maschinen der nächsten Generation bauen.

"Mehr als 1.000 Kunden und 150 Partner haben sich für Jetson AGX Orin entschieden, seit NVIDIA die Verfügbarkeit vor nur sechs Monaten bekannt gegeben hat, und Orin Nano wird diese Akzeptanz deutlich erhöhen", sagte Deepu Talla, Vice President of Embedded and Edge Computing bei NVIDIA. "Mit einer um Größenordnungen gesteigerten Leistung für Millionen von Edge-KI- und ROS-Entwicklern ist Jetson Orin die ideale Plattform für praktisch jede Art von Robotikeinsatz, die man sich vorstellen kann."

Erleichterung des Zugangs zu Edge-KI und Robotik

Die Orin Nano-Module sind formfaktor- und pin-kompatibel mit den bereits angekündigten Orin NX-Modulen. Dank der vollständigen Emulationsunterstützung können Kunden bereits heute mit der Entwicklung für die Orin Nano-Serie beginnen, indem sie das AGX Orin-Entwickler-Kit verwenden. Dies gibt den Kunden die Flexibilität, ein System zur Unterstützung mehrerer Jetson-Module zu entwickeln und ihre Anwendungen einfach zu skalieren.

Orin Nano unterstützt mehrere gleichzeitige KI-Anwendungspipelines mit Hochgeschwindigkeits-I/O und einer NVIDIA Ampere-Architektur-GPU. Entwickler von Einstiegsgeräten und Anwendungen wie Einzelhandelsanalysen und industrielle Qualitätskontrolle profitieren von einem leichteren Zugang zu komplexeren KI-Modellen zu geringeren Kosten.

Die Orin Nano-Module werden in zwei Versionen erhältlich sein: Der Orin Nano 8GB kann bis zu 40 TOPS bei einer konfigurierbaren Leistungsaufnahme von 7W bis 15W liefern, während die 4GB-Version bis zu 20 TOPS bei einer Leistungsaufnahme von nur 5W bis 10W bietet.

Die Jetson Orin Plattform wurde entwickelt, um die schwierigsten Herausforderungen in der Robotik zu lösen und bietet über 700.000 ROS-Entwicklern beschleunigte Rechenleistung. In Kombination mit den leistungsstarken Hardware-Fähigkeiten des Orin Nano sorgen die Verbesserungen in der neuesten NVIDIA Isaac-Software für ROS für eine höhere Leistung und Produktivität der Robotiker.

Starkes Ökosystem und Software-Unterstützung

Der Jetson Orin findet breite Unterstützung im gesamten Robotik- und Embedded-Computing-Ökosystem, darunter von Canon, John Deere, Microsoft Azure, Teradyne, TK Elevator und vielen anderen.

Das NVIDIA Jetson Ökosystem wächst schnell, mit über 1 Million Entwicklern, 6.000 Kunden - darunter 2.000 Startups - und 150 Partnern. Die Jetson-Partner bieten ein breites Spektrum an Unterstützung, von KI-Software, Hardware und Anwendungsdesign-Services bis hin zu Kameras, Sensoren und Peripheriegeräten, Entwickler-Tools und Entwicklungssystemen.

NVIDIA Jetson Familie Orin-basierte Produktionsmodule

Jetson Orin Nano 8GB und 4GB Module

Die Module der NVIDIA Jetson Orin Nano Serie liefern bis zu 40 TOPS an KI-Leistung im kleinsten Jetson-Formfaktor, mit Leistungsoptionen zwischen 5W und 15W. Damit erhalten Sie die bis zu 80-fache Leistung des NVIDIA Jetson Nano und setzen den neuen Standard für Edge-KI der Einstiegsklasse.

Beide Jetson Orin Nano Module werden ab Januar 2023 erhältlich sein

Jetson AGX Orin 64GB und 32GB Module

NVIDIA Jetson AGX Orin Module liefern bis zu 275 TOPS an KI-Leistung bei einer konfigurierbaren Leistungsaufnahme zwischen 15W und 60W. Damit erhalten Sie die bis zu 8-fache Leistung von Jetson AGX Xavier im gleichen kompakten Formfaktor für Robotik und andere autonome Maschinenanwendungen.

Das Jetson AGX Orin 32GB Modul ist ab sofort erhältlich.

Jetson AGX Orin 64GB wird ab Dezember 2022 erhältlich sein.

Jetson Orin NX 16GB und 8GB Module

Jetson Orin NX-Module liefern bis zu 100 TOPS an KI-Leistung im kleinsten Jetson-Formfaktor, wobei die Leistung zwischen 10 und 25 W konfigurierbar ist. Damit erhalten Sie die bis zu 3-fache Leistung von Jetson AGX Xavier und die bis zu 5-fache Leistung von Jetson Xavier NX.

Jetson Orin NX 16GB wird ab Dezember 2022 erhältlich sein.

Jetson Orin NX 8GB wird im Januar 2023 verfügbar sein.

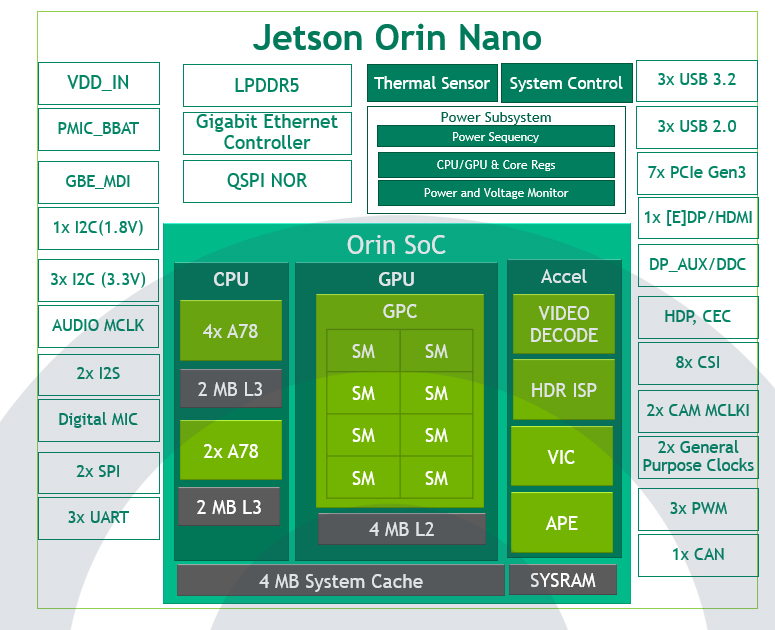

Ein detaillierter Blick auf die Jetson Orin Nano 8GB und 4GB Module

*Die NVIDIA Orin Architektur von Jetson Orin Nano 8GB, Jetson Orin Nano 4GB hat 2 TPCs und 4 SMs.

Wie in Abbildung 1 dargestellt, präsentiert der Jetson Orin Nano die NVIDIA Orin Architektur mit einer NVIDIA Ampere Architecture GPU. Er verfügt über bis zu acht Streaming-Multiprozessoren (SMs), die aus 1024 CUDA-Kernen und bis zu 32 Tensor-Kernen für die KI-Verarbeitung bestehen.

Die NVIDIA Ampere Architecture Tensor Cores der dritten Generation liefern eine bessere Leistung pro Watt als die Vorgängergeneration und bringen mehr Leistung durch Unterstützung von Sparsity. Mit Sparsity können Sie die feinkörnige strukturierte Sparsity in Deep-Learning-Netzwerken nutzen, um den Durchsatz für Tensor-Core-Operationen zu verdoppeln.

Um alle Teile Ihrer Anwendungspipeline zu beschleunigen, enthält der Jetson Orin Nano außerdem eine 6-Core Arm Cortex-A78AE CPU, eine Videodekodierungs-Engine, einen ISP, einen Videobild-Compositor, eine Audioverarbeitungs-Engine und einen Videoeingabeblock.

Die Jetson Orin Nano -Module haben eine kleine Grundfläche von 70 x 45 mm und verfügen über 260-Pin-SODIMMs sowie verschiedene Hochgeschwindigkeitsschnittstellen:

- Bis zu sieben Lanes PCIe Gen3

- Drei 10-Gbps-Hochgeschwindigkeits-USB 3.2 Gen2-Anschlüsse

- Acht Lanes von MIPI CSI-2 Kameraanschlüssen

- Verschiedene Sensor-E/A

Um Ihren Entwicklungsaufwand zu reduzieren, haben wir die Jetson Orin Nano und Jetson Orin NX Module vollständig Pin- und Formfaktor-kompatibel gemacht. Tabelle 1 zeigt die Unterschiede zwischen dem Jetson Orin Nano 4GB und dem Jetson Orin Nano 8GB.

| Spezifikationen | Jetson Orin Nano 4GB | Jetson Orin Nano 8GB |

| KI-Leistung | 20 Sparse TOPs | 10 Dense TOPs | 40 Sparse TOPs | 20 Dense TOPs |

| GPU | 512-Kern NVIDIA Ampere-Architektur-GPU mit 16 Tensor-Kernen | nVIDIA Ampere-Architektur-GPU mit 1024 Kernen und 32 Tensor-Kernen |

| GPU Max Frequenz | 625 MHz | |

| CPU | 6-Kern Arm Cortex-A78AE v8.2 64-Bit CPU 1,5 MB L2 + 4 MB L3 | |

| CPU Max Frequenz | 1.5 GHz | |

| Speicher | 4 GB 64-Bit LPDDR5 34 GB/s | 8 GB 128-Bit-LPDDR5 68 GB/s |

| Speicher | - | |

| (Unterstützt externes NVMe) | ||

| Video-Codierung | 1080p30 unterstützt von 1-2 CPU-Kernen | |

| Video-Dekodierung | 1x 4K60 (H.265) | 2x 4K30 (H.265) | 5x 1080p60 (H.265) | 11x 1080p30 (H.265) | |

| Kamera | Bis zu 4 Kameras (8 über virtuelle Kanäle*) 8 Lanes MIPI CSI-2 D-PHY 2.1 (bis zu 20 Gbps) | |

| PCIe | 1 x4 + 3 x1 (PCIe Gen3, Root Port und Endpunkt) | |

| USB | 3x USB 3.2 Gen2 (10 Gbit/s) 3x USB 2.0 | |

| Vernetzung | 1x GbE | |

| Anzeige | 1x 4K30 Multimode DisplayPort 1.2 (+MST)/e DisplayPort 1.4/HDMI 1.4* | |

| Andere E/A | 3x UART, 2x SPI, 2x I2S, 4x I2C, 1x CAN, DMIC und DSPK, PWM, GPIOs | |

| Leistung | 5W - 10W | 7W - 15W |

| Mechanisch | 69.6 mm x 45 mm 260-poliger SO-DIMM-Anschluss | |

| Preis | $199† | $299† |

* Weitere Informationen über zusätzliche Kompatibilität zu DisplayPort 1.4a und HDMI 2.1 sowie virtuelle Kanäle finden Sie im Datenblatt der Jetson Orin Nano-Serie. † 1KU Volumen

Weitere Informationen zu den unterstützten Funktionen finden Sie im Abschnitt "Software Features" des aktuellen NVIDIA Jetson Linux Developer Guide.

Leistungsbenchmarks mit Jetson Orin Nano

Mit Jetson AGX Orin ist NVIDIA führend in der Kategorie Inferenzleistung von MLPerf. Die Jetson Orin-Module bieten einen riesigen Fortschritt für Ihre Anwendungen der nächsten Generation, und jetzt wird die gleiche NVIDIA Orin-Architektur für KI-Geräte der Einstiegsklasse zugänglich gemacht.

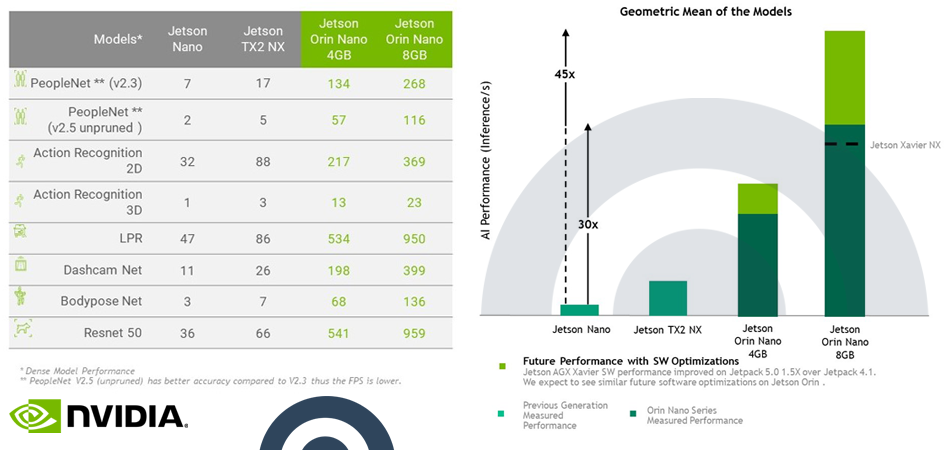

NVIDIA hat den Emulationsmodus mit NVIDIA JetPack 5.0.2 verwendet, um Computer-Vision-Benchmarks mit dem Jetson Orin Nano durchzuführen, und die Ergebnisse zeigen, dass er den neuen Standard setzt. Die Tests umfassten einige unserer dichten INT8- und FP16-Vortrainingsmodelle von NGC sowie ein Standard-ResNet-50-Modell. Die gleichen Modelle wurden zum Vergleich auch auf dem Jetson Nano, TX2 NX und Xavier NX ausgeführt.

Hier finden Sie die vollständige Liste der Benchmarks:

- NVIDIA PeopleNet v2.3 für beschnittene Personenerkennung und NVIDIA PeopleNet v2.5 für die Personenerkennung mit der höchsten Genauigkeit

- NVIDIA ActionRecognitionNet 2D- und 3D-Modelle

- NVIDIA LPRNet für die Erkennung von Nummernschildern

- NVIDIA DashCamNet, BodyPoseNet für die Schätzung der Körperhaltung von mehreren Personen

- ResNet-50 (224×224) Modell

Nimmt man den Geomean dieser Benchmarks, zeigt der Jetson Orin Nano 8GB eine 30-fache Leistungssteigerung im Vergleich zum Jetson Nano. Mit zukünftigen Softwareverbesserungen rechnet NVIDIA mit einer 45-fachen Leistungssteigerung. Andere Jetson-Geräte haben ihre Leistung seit der ersten unterstützenden Softwareversion um das 1,5-fache gesteigert, und NVIDIA erwartet das Gleiche für den Jetson Orin Nano.