In diesem artikel:

Google Edge TPU - Was ist das? Und wie funktioniert es?

Assured Systems bieten eine Vielzahl von Produkten mit Google Edge TPU für eine breite Palette von Anwendungen. Erfahren Sie mehr darüber, was Google Edge TPU ist, wie es funktioniert und wie es Ihnen nützen könnte.

Künstliche Intelligenz (KI) ist eine Technologie, die es einem Computer ermöglicht, auf "menschlichere" Weise zu denken oder zu handeln, indem er Informationen aus seiner Umgebung aufnimmt und seine Reaktion auf der Grundlage dessen, was er lernt oder wahrnimmt, festlegt - und von Verbraucher- bis zu Unternehmensanwendungen ist KI heute allgegenwärtig.

Künstliche Intelligenz (KI) ist eine Technologie, die es einem Computer ermöglicht, auf "menschlichere" Weise zu denken oder zu handeln, indem er Informationen aus seiner Umgebung aufnimmt und seine Reaktion auf der Grundlage dessen, was er lernt oder wahrnimmt, festlegt - und von Verbraucher- bis zu Unternehmensanwendungen ist KI heute allgegenwärtig.

Angesichts der rasanten Zunahme vernetzter Geräte und der Forderung nach Datenschutz/Vertraulichkeit, geringen Latenzzeiten und Bandbreitenbeschränkungen müssen KI-Modelle, die in der Cloud trainiert wurden, zunehmend am Edge ausgeführt werden - was einfach bedeutet, dass das Gerät die KI-Anwendung unabhängig ausführen kann, ohne Daten über eine Internetverbindung an einen Server zurücksenden zu müssen.

Was also ist Google Edge TPU?

Google Edge TPU ist Googles eigens entwickelter ASIC (Application Specific Integrated Circuit - optimiert für die Ausführung einer bestimmten Art von Anwendung), der für die Ausführung von KI im Edge-Bereich entwickelt wurde. Er bietet hohe Leistung bei geringem Platz- und Stromverbrauch und ermöglicht so den Einsatz von hochpräziser KI am Edge.

Google Edge TPU ergänzt Cloud TPU und Google Cloud Services, um eine End-to-End, Cloud-to-Edge,  Hardware- und Software-Infrastruktur für die Bereitstellung von KI-basierten Lösungen für Kunden zu bieten.

Hardware- und Software-Infrastruktur für die Bereitstellung von KI-basierten Lösungen für Kunden zu bieten.

Aber wie?

Nun, die Edge TPU ermöglicht es Ihnen, hochwertige ML-Inferencing am Rande einzusetzen, unter Verwendung verschiedener Prototyping- und Produktionsprodukte von Coral.

Die Coral-Plattform für ML am Edge ergänzt Googles Cloud TPU und Cloud IoT, um eine End-to-End-Infrastruktur (Cloud-to-Edge, Hardware und Software) bereitzustellen, die die Bereitstellung von KI-basierten Lösungen der Kunden erleichtert. Die Coral-Plattform bietet ein komplettes Entwickler-Toolkit, mit dem Sie Ihre eigenen Modelle kompilieren oder mehrere KI-Modelle von Google für die Edge TPU neu trainieren können, wobei Googles Fachwissen im Bereich KI und Hardware kombiniert wird.

Die Google Edge TPU ergänzt CPUs, GPUs, FPGAs und andere ASIC-Lösungen für die Ausführung von KI am Edge.

Cloud vs. Edge

Die Ausführung von Code in der Cloud bedeutet, dass Sie CPUs, GPUs und TPUs eines Unternehmens nutzen, das Ihnen diese über Ihren Browser zur Verfügung stellt. Der Hauptvorteil der Ausführung von Code in der Cloud besteht darin, dass Sie die erforderliche Rechenleistung für diesen speziellen Code zuweisen können (das Training großer Modelle kann sehr rechenintensiv sein)

Der Edge ist das Gegenteil der Cloud. Es bedeutet, dass Sie Ihren Code vor Ort ausführen (was im Grunde bedeutet, dass Sie das Gerät, auf dem der Code ausgeführt wird, physisch berühren können). Der Hauptvorteil der Edge-Ausführung von Code ist, dass es keine Netzwerklatenz gibt. Da IoT-Geräte in der Regel häufig Daten generieren, eignet sich die Ausführung von Code auf dem Edge perfekt für IoT-basierte Lösungen

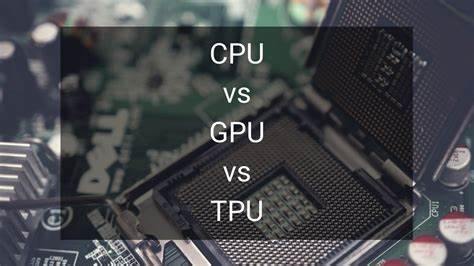

Was ist der Unterschied zwischen TPU, CPU und GPU?

Eine TPU (Tensor Processing Unit) ist eine andere Art von Verarbeitungseinheit wie eine CPU oder eine GPU. Es gibt jedoch einige große Unterschiede zwischen ihnen - der größte Unterschied ist, dass TPU ein ASIC ist. Und wie Sie wahrscheinlich bereits wissen, sind CPUs und GPUs keine ASICs, da sie nicht für eine bestimmte Art von Anwendung optimiert sind.

Eine TPU (Tensor Processing Unit) ist eine andere Art von Verarbeitungseinheit wie eine CPU oder eine GPU. Es gibt jedoch einige große Unterschiede zwischen ihnen - der größte Unterschied ist, dass TPU ein ASIC ist. Und wie Sie wahrscheinlich bereits wissen, sind CPUs und GPUs keine ASICs, da sie nicht für eine bestimmte Art von Anwendung optimiert sind.

Da wir CPUs, GPUs und TPUs vergleichen, wollen wir uns kurz ansehen, wie sie jeweils Multiplikations- und Additionsoperationen mit ihrer Architektur durchführen:

- Eine CPU führt die Multiplikations-Addier-Operation durch, indem sie jede Eingabe und jedes Gewicht aus dem Speicher liest, sie mit ihrer ALU (Arithmetic Logic Unit) multipliziert, sie zurück in den Speicher schreibt und schließlich alle multiplizierten Werte addiert. Moderne CPUs verfügen über einen großen Zwischenspeicher, Verzweigungsvorhersage und eine hohe Taktrate für jeden Kern. Dies alles trägt zu einer geringeren Latenzzeit der CPU bei.

- Ein Grafikprozessor verfügt jedoch nicht über die ausgefallenen Funktionen, die die Latenzzeit verringern. Sie muss auch ihre Tausende von ALUs orchestrieren, was die Latenz weiter verringert. Kurz gesagt, GPUs erhöhen ihren Durchsatz drastisch, indem sie ihre Berechnungen parallelisieren und im Gegenzug ihre Latenzzeit erhöhen.

- Eine TPU hingegen arbeitet ganz anders. Ihre ALUs sind direkt miteinander verbunden, ohne den Speicher zu nutzen. Sie können Informationen direkt weitergeben, was die Latenzzeit drastisch verringert.

Zusammenfassend lässt sich sagen, dass die Edge-TPU Schlussfolgerungen schneller durchführt als jede andere Architektur von Verarbeitungseinheiten. Sie ist nicht nur schneller, sondern auch umweltfreundlicher, da sie die Quantisierung nutzt und weniger Speicheroperationen benötigt.